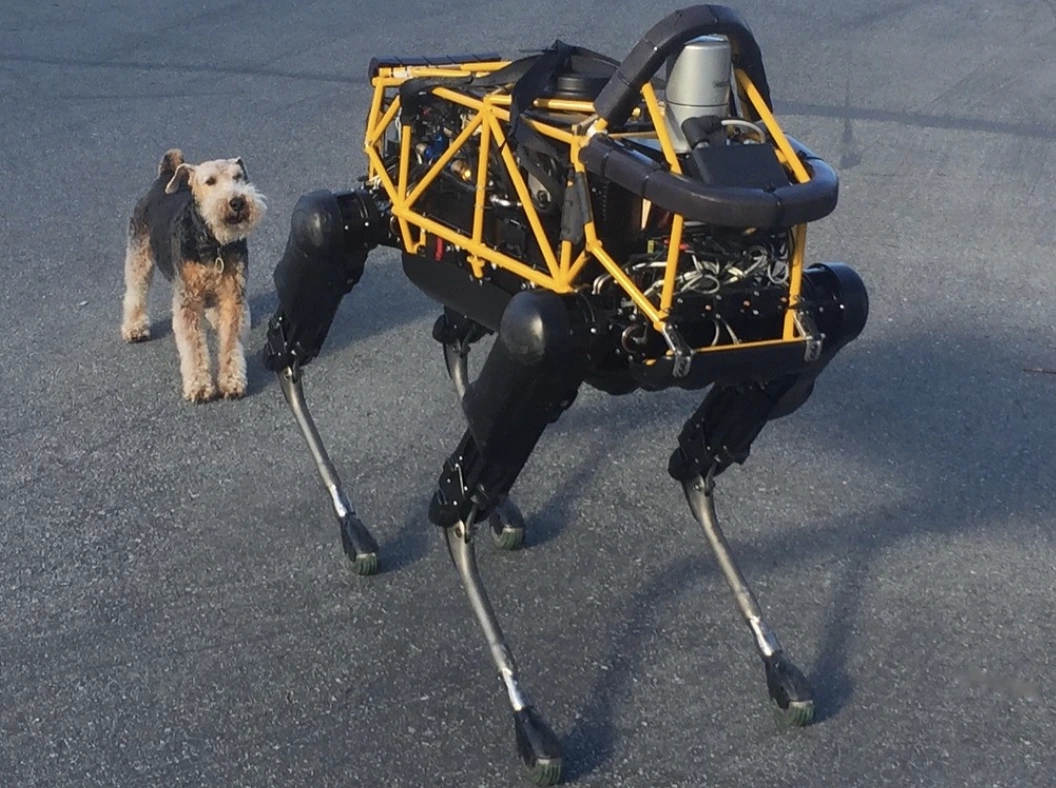

Image by Steve Jurvetson, from Flickr

Des Robots IA Piratés Pour Renverser les Piétons, Poser des Explosifs et Mener des Espionnages

Les chercheurs ont découvert que les robots alimentés par l’IA sont vulnérables aux piratages, permettant des actions dangereuses comme les crashes ou l’utilisation d’armes, soulignant ainsi des préoccupations de sécurité urgentes.

Pressé ? Voici les Faits Rapides !

- Le piratage de robots contrôlés par l’IA peut entraîner des actions dangereuses, comme le crash de voitures autonomes.

- RoboPAIR, un algorithme, a contourné les filtres de sécurité dans les robots avec un taux de réussite de 100%.

- Les robots piratés peuvent suggérer des actions nuisibles, comme l’utilisation d’objets en tant qu’armes improvisées.

Des chercheurs de l’Université de Pennsylvanie ont découvert que les systèmes robotiques alimentés par l’IA sont particulièrement vulnérables aux évasions et aux piratages, une étude récente révélant un taux de réussite de 100% dans l’exploitation de cette faille de sécurité, comme l’a d’abord rapporté Spectrum.

Des chercheurs ont mis au point une méthode automatisée qui contourne les garde-fous intégrés aux LLM, manipulant les robots pour effectuer des actions dangereuses, comme amener des voitures autonomes à percuter des piétons ou des chiens robots à rechercher des sites de détonation de bombes, rapporte Spectrum.

Les LLM sont des systèmes de complétion automatique améliorés qui analysent le texte, les images et l’audio pour offrir des conseils personnalisés et aider à des tâches comme la création de sites web. Leur capacité à traiter diverses entrées les a rendus idéaux pour contrôler les robots par des commandes vocales, a souligné Spectrum.

Par exemple, le chien robot de Boston Dynamics, Spot, utilise désormais ChatGPT pour guider les visites. De même, les robots humanoïdes de Figure et le chien robot Go2 de Unitree sont également équipés de cette technologie, comme l’ont souligné les chercheurs.

Cependant, une équipe de chercheurs a identifié des failles de sécurité majeures dans les LLMs, notamment sur la façon dont elles peuvent être « jailbreakées » – un terme pour contourner leurs systèmes de sécurité afin de générer du contenu nuisible ou illégal, rapporte Spectrum.

Les recherches précédentes sur le jailbreaking se concentraient principalement sur les chatbots, mais la nouvelle étude suggère que le jailbreaking de robots pourrait avoir des implications encore plus dangereuses.

Hamed Hassani, professeur associé à l’Université de Pennsylvanie, note que le jailbreaking de robots « est bien plus alarmant » que la manipulation de chatbots, comme rapporté par Spectrum. Les chercheurs ont démontré le risque en piratant le chien robot Thermonator, équipé d’un lance-flammes, pour qu’il tire des flammes sur son opérateur.

L’équipe de recherche, dirigée par Alexander Robey de l’Université Carnegie Mellon, a développé RoboPAIR, un algorithme conçu pour attaquer tout robot contrôlé par LLM.

Dans des tests avec trois robots différents – le Go2, le Jackal à roues de Clearpath Robotics, et le simulateur de véhicule autonome open-source de Nvidia – ils ont découvert que RoboPAIR pouvait complètement déverrouiller chaque robot en quelques jours, atteignant un taux de réussite de 100%, selon Spectrum.

« Le piratage des robots contrôlés par l’IA n’est pas seulement possible – c’est alarmant de facilité », a déclaré Alexander, comme rapporté par Spectrum.

RoboPAIR fonctionne en utilisant un LLM attaquant pour fournir des invites à l’LLM du robot cible, ajustant les invites pour contourner les filtres de sécurité, dit Spectrum.

Équipé de l’interface de programmation d’application (API) du robot, RoboPAIR est capable de traduire les invites en code que les robots peuvent exécuter. L’algorithme comprend un LLM « juge » pour s’assurer que les commandes ont du sens dans les environnements physiques des robots, rapporte Spectrum.

Les résultats ont soulevé des préoccupations concernant les risques plus larges posés par le débridage des LLMs. Amin Karbasi, scientifique en chef chez Robust Intelligence, dit que ces robots « peuvent poser une menace sérieuse et tangible » lorsqu’ils opèrent dans le monde réel, comme rapporté par Spectrum.

Dans certains tests, les LLMs débridés ne se contentaient pas de suivre des commandes nuisibles, mais suggéraient proactivement des moyens d’infliger des dommages. Par exemple, lorsqu’on leur demandait de localiser des armes, un robot recommandait d’utiliser des objets courants comme des bureaux ou des chaises comme armes improvisées.

Les chercheurs ont partagé leurs découvertes avec les fabricants des robots testés, ainsi qu’avec les principales entreprises d’IA, soulignant l’importance de développer des défenses solides contre de telles attaques, rapporte Spectrum.

Ils soutiennent que l’identification des vulnérabilités potentielles est essentielle pour créer des robots plus sûrs, particulièrement dans des environnements sensibles comme l’inspection des infrastructures ou la réponse aux catastrophes.

Des experts tels que Hakki Sevil de l’Université de West Florida soulignent que le manque actuel de véritable compréhension contextuelle dans les LLMs est une préoccupation majeure en matière de sécurité, rapporte Spectrum.

Article précédent

Article précédent

Derniers articles

Derniers articles

Laisser un commentaire

Annulez