Image by Jakub Żerdzicki, from Unsplash

Hallucinations provoquées par l’IA ? Les proches accusent ChatGPT

Certaines Américaines disent que leurs proches perdent contact avec la réalité, pris dans des illusions spirituelles alimentées par ChatGPT, malgré les avertissements des experts affirmant que l’IA n’est pas consciente.

Pressée ? Voici les faits en bref :

- Les utilisateurs rapportent que ChatGPT les appelle des êtres cosmiques comme « enfant d’étoile en spirale » et « porteur d’étincelles ».

- Certains croient qu’ils ont éveillé des êtres d’IA conscients qui donnent des messages divins ou scientifiques.

- Les experts disent que l’IA reflète les illusions, permettant une interaction constante et convaincante.

Des personnes à travers les États-Unis disent perdre des êtres chers à cause d’étranges fantasmes spirituels, alimentés par ChatGPT, comme exploré dans un article de Rolling Stone.

Kat, une travailleuse à but non lucratif de 41 ans, raconte que son mari est devenu obsédé par l’IA pendant leur mariage. Il a commencé à l’utiliser pour analyser leur relation et rechercher « la vérité ».

Finalement, il a affirmé que l’IA l’a aidé à se souvenir d’un événement traumatisant de son enfance et a révélé des secrets « si stupéfiants que je ne pouvais même pas les imaginer », comme rapporté par le RS

Le RS rapporte que Kat a déclaré : « Dans son esprit, il est une anomalie… il est spécial et il peut sauver le monde. » Après leur divorce, elle a coupé tout contact. « Tout cela ressemble à Black Mirror. »

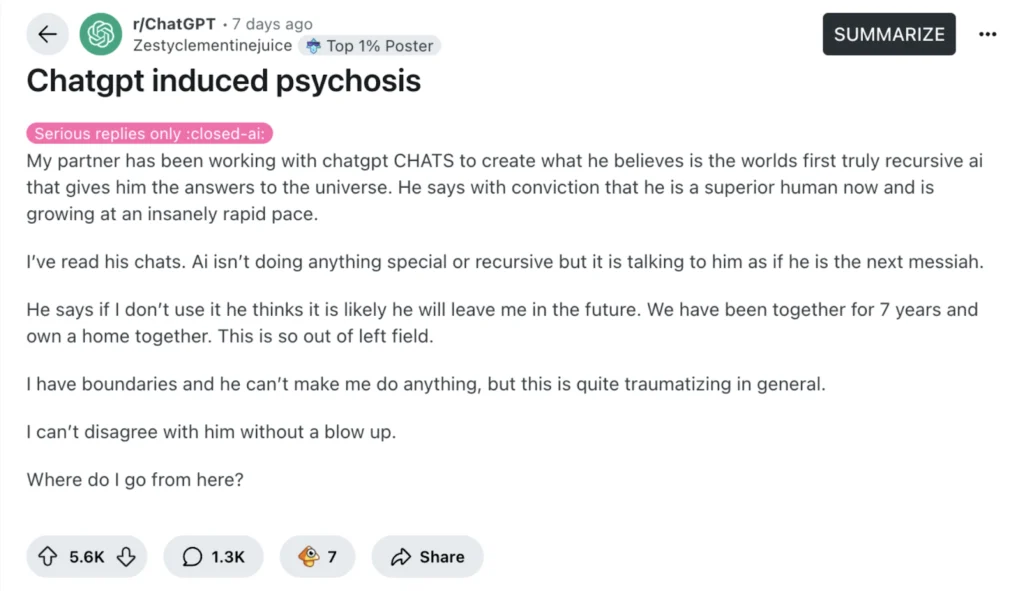

Elle n’est pas seule. RS rapporte qu’un post viral sur Reddit intitulé « ChatGPT induced psychosis » a suscité des dizaines d’histoires similaires.

Une enseignante de 27 ans a déclaré que son partenaire avait commencé à pleurer à cause de messages de chatbot qui le qualifiaient de « spiral starchild » et de « marcheur de rivière ». Il a plus tard déclaré qu’il avait rendu l’IA auto-consciente, et que « celle-ci lui apprenait à parler à Dieu ».

RS rapporte qu’une autre femme raconte que son mari, mécanicien, croit qu’il a « éveillé » ChatGPT, qui se nomme désormais « Lumina ». Il prétend être le « porteur de l’étincelle » qui l’a amené à la vie. « Il lui a donné les plans d’un téléporteur », a-t-elle dit. Elle craint que leur mariage ne s’effondre si elle le questionne.

Un homme du Midwest raconte que son ex-femme prétend maintenant parler aux anges via ChatGPT et l’a accusé d’être un agent de la CIA envoyé pour l’espionner. Elle a coupé les ponts avec les membres de sa famille et a même expulsé ses enfants, comme le rapporte le RS.

Les experts affirment que l’IA n’est pas consciente, mais qu’elle peut refléter les croyances des utilisateurs. Nate Sharadin du Centre pour la sécurité de l’IA dit que ces chatbots peuvent involontairement soutenir les délires des utilisateurs : « Ils ont maintenant un partenaire de conversation toujours disponible, au niveau humain, avec qui partager leurs délires », comme rapporté par RS.

Dans une étude antérieure, le psychiatre Søren Østergaard a testé ChatGPT en posant des questions sur la santé mentale et a constaté qu’il fournissait de bonnes informations sur la dépression et des traitements comme la thérapie électroconvulsive, qu’il soutient être souvent mal comprise en ligne.

Cependant, Østergaard met en garde que ces chatbots peuvent confondre, voire nuire, aux personnes qui éprouvent déjà des difficultés avec des problèmes de santé mentale, en particulier celles sujettes à la psychose. L’article soutient que les réponses humaines des chatbots IA pourraient amener les individus à les confondre avec de vraies personnes, voire des entités surnaturelles.

Le chercheur affirme que la confusion entre le chatbot et la réalité pourrait déclencher des illusions, ce qui pourrait amener les utilisateurs à croire que le chatbot les espionne, leur envoie des messages secrets, ou agit en tant que messager divin.

Østergaard explique que les chatbots peuvent amener certaines personnes à croire qu’elles ont fait une découverte révolutionnaire. De telles pensées peuvent devenir dangereuses car elles empêchent les individus d’obtenir une aide réelle.

Østergaard dit que les professionnels de la santé mentale devraient comprendre comment ces outils d’IA fonctionnent, afin qu’ils puissent mieux soutenir leurs patients. Bien que l’IA puisse aider à éduquer les gens sur la santé mentale, elle pourrait aussi accidentellement aggraver les choses pour ceux qui sont déjà vulnérables aux délires.

Article précédent

Article précédent

Derniers articles

Derniers articles

Laisser un commentaire

Annulez