Qu’est-ce que la latence et comment l’améliorer ? Guide en 2025

Le temps de latence est le temps nécessaire pour que les données voyagent de votre appareil à sa destination et vice-versa. Ce délai peut donner l’impression que votre internet est lent, en particulier pour les activités qui nécessitent des réponses rapides, comme les jeux et les appels vidéo. Lorsque le temps de latence est élevé, vous pouvez constater des décalages ou des retards entre ce que vous faites et ce qui se passe à l’écran.

La réduction de la latence peut rendre votre expérience en ligne plus fluide. Des actions simples comme l’optimisation de vos paramètres Internet ou la mise à niveau de votre équipement peuvent vous aider. Dans ce guide, vous apprendrez ce qu’est la latence, quelles en sont les causes et comment l’améliorer. NDLR : Nous accordons une grande importance à notre relation avec nos lecteurs et nous nous efforçons de gagner leur confiance de par notre transparence et notre intégrité. Nous appartenons au même groupe de propriétaires que certains des produits phares présentés sur ce site : Intego, Cyberghost, ExpressVPN et Private Internet Access. Cependant, cela n’affecte en rien notre méthode d’évaluation, car nous respectons une méthodologie de test stricte.

Résumé rapide : qu’est-ce que la latence ?

La latence est souvent confondue avec la bande passante et le ping, mais chacune de ces notions est différente. La bande passante est la quantité de données que votre connexion peut traiter, tandis que la latence est le temps total nécessaire pour que les données fassent un aller-retour, en tenant compte de tous les retards. Le ping est un outil permettant de mesurer la latence : il envoie un signal à un serveur pour mesurer ce temps d’aller-retour.

Lorsque vous cliquez sur un lien ou chargez une vidéo, cette demande est transmise à un serveur qui renvoie le contenu. Le temps que prend cet aller-retour est la latence. Une latence élevée peut donner l’impression que les choses sont lentes. Elle est à l’origine de décalages dans le streaming, de retards dans les appels vidéo et de moments de non-réponse dans les jeux en ligne. Le temps de latence est mesuré en millisecondes (ms) et des chiffres plus bas signifient de meilleures performances.

Types de latence

La latence se présente sous de nombreuses formes, chacune affectant votre expérience en ligne de différentes manières. Connaître ces types de latence peut vous aider à identifier des retards spécifiques et à mieux comprendre comment les données circulent dans différents systèmes. Voici un aperçu des principaux types de latence :

- Latence du réseau : délai de transmission des données sur les réseaux, influencé par la distance, l’encombrement du réseau et les chemins pris entre les appareils.

- Latence du disque : délai d’accès ou de stockage des données sur un périphérique, impliquant le temps de recherche, les délais de rotation du disque et la vitesse de transfert entre ces périphériques.

- Latence de traitement : temps nécessaire aux systèmes pour interpréter, vérifier les erreurs et traiter les données avant de les envoyer sur le réseau.

- Délai de propagation : temps de parcours d’un signal sur un support, affecté par la distance physique entre les appareils connectés.

- Délai de transmission : durée nécessaire pour acheminer tous les paquets de données sur le réseau, en fonction de la taille de ces paquets et de la largeur de bande passante.

- Délai de mise en file d’attente : temps d’attente d’un paquet dans une file d’attente pendant qu’un dispositif de réseau traite d’autres paquets de données.

- Latence d’interruption : intervalle entre le moment où un dispositif génère une interruption et le moment où le processeur commence à la traiter, ce qui est vital dans les systèmes en temps réel.

- Latence de la fibre optique : délai minimal dans la transmission par un câble à fibre optique, influencé par la vitesse de la lumière à travers celui-ci.

- Latence Internet : délai total de transmission des données sur Internet, y compris la latence du réseau, les chemins parcourus et les temps de traitement des serveurs.

Latence, débit, bande passante : quelle est la différence ?

La latence, le débit et la bande passante ont tous une incidence différente sur votre expérience Internet, en influant sur la vitesse, la réactivité et la capacité des données. Savoir comment ces éléments fonctionnent ensemble peut vous aider à identifier et à résoudre les problèmes qui vous ralentissent en ligne.

- Latence : il s’agit du délai de transmission des données entre votre appareil et un serveur et inversement, mesuré en millisecondes (ms). Une latence élevée entraîne des décalages dans les jeux, les appels vidéo et d’autres activités en ligne. Vous pouvez vérifier votre latence en effectuant un test ping, qui indique le délai entre l’envoi et la réception des données.

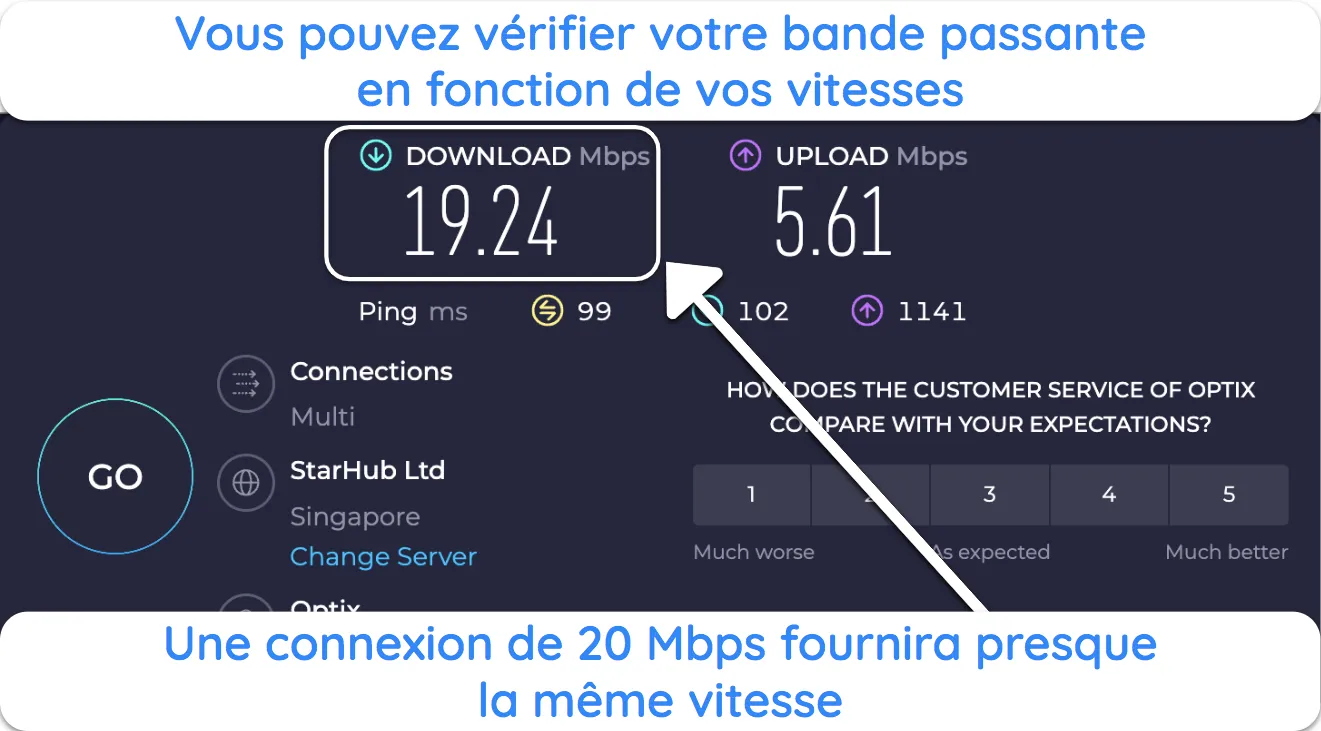

- Largeur de bande : il s’agit de la quantité maximale de données que votre connexion peut traiter en même temps, mesurée en Mbps ou en Gbps. C’est comme la largeur d’une autoroute : plus la bande passante est importante, plus il y a de données qui peuvent circuler en même temps. Vous pouvez mesurer la bande passante à l’aide de tests de vitesse en ligne qui révèlent la capacité de votre connexion.

![Capture d'écran du résultat du test de vitesse d'Ookla.]() Vous pouvez obtenir des vitesses inférieures à votre bande passante en raison d’une congestion de réseau ou de périphériques partagés

Vous pouvez obtenir des vitesses inférieures à votre bande passante en raison d’une congestion de réseau ou de périphériques partagés - Débit : il s’agit de la quantité réelle de données transférées avec succès pour votre connexion et en temps réel. Il est mesuré en Mbps ou Gbps et est affecté par des facteurs tels que la congestion d’un réseau et autres limites matérielles. Vous pouvez mesurer le débit en vérifiant vos vitesses de téléchargement et d’envoi actuelles et en les comparant à la bande passante.

Exigences de latence pour différentes activités

Les exigences en matière de latence, de bande passante et de débit varient selon les activités en ligne. Utilisez le tableau ci-dessous pour connaître les valeurs idéales pour avoir une expérience fluide dans chaque activité.

| Activité | Temps de latence (ms) | Largeur de bande (Mbps) | Débit (Mbps) | Impact d’une latence élevée et d’une faible largeur de bande/débit |

| Navigation sur Internet | < 100 | De 1 à 5 | De 1 à 5 | Les pages peuvent se charger lentement ; les images et les vidéos peuvent prendre plus de temps à s’afficher. |

| Streaming vidéo | < 100 | De 3 à 25 | De 3 à 25 | Problèmes de mise en mémoire tampon ; baisse de la qualité vidéo ; interruptions fréquentes |

| Jeux en ligne | < 50 | De 1 à 3 | De 1 à 3 | Lag, réponses retardées et jeu peu réactif |

| Appel vidéo | < 150 | De 1 à 4 | De 1 à 4 | Retards dans l’audio/vidéo ; mauvaise qualité ; déconnexions |

| Téléchargement de fichiers | < 200 | De 5 à 50 | De 5 à 50 | Vitesses de téléchargement plus lentes ; temps d’attente plus longs pour les fichiers volumineux |

| Applications Cloud | < 100 | De 1 à 10 | De 1 à 10 | Synchronisation des données retardée ; lenteur des outils de collaboration en temps réel |

Note : ces valeurs sont approximatives et peuvent varier en fonction des applications spécifiques et des conditions du réseau.

Comment fonctionne le temps de latence ?

Quoi que vous fassiez en ligne, les données doivent voyager en plusieurs étapes entre votre appareil et un ou plusieurs serveurs. Bien que la communication se fasse à des vitesses éclair, chaque étape ajoute un petit délai.

- Initiation d’une demande : lorsque vous cliquez sur un lien ou envoyez un message, votre appareil crée des paquets de données contenant votre demande.

- Transmission sur le réseau local : ces paquets transitent d’abord par votre réseau domestique, en passant par votre routeur et votre modem.

- Routage ISP : à partir de votre routeur, les données sont acheminées vers votre fournisseur d’accès à Internet (FAI), qui les dirige via le modem vers le serveur de destination.

- Transit par la dorsale Internet : les données traversent les principales voies Internet, en passant éventuellement par plusieurs routeurs et réseaux.

- Réception et traitement par le serveur : le serveur de destination reçoit les paquets, traite votre demande et prépare une réponse.

- Trajet de retour : le serveur renvoie la réponse en suivant le même chemin jusqu’à votre appareil.

Quelles sont les causes de la latence ?

Chaque retard que vous rencontrez a une cause profonde, depuis le chemin physique parcouru par les données jusqu’à la technologie que vous utilisez. Voici une analyse de ce qui peut être à l’origine de votre latence :

- Distance physique : plus les données doivent voyager loin entre votre appareil et le serveur, plus le délai est long. Par exemple, l’accès à un serveur situé à l’étranger augmentera le temps de latence par rapport à un serveur situé dans votre région.

- Congestion du réseau : lorsque trop d’utilisateurs ou d’appareils partagent le même réseau, les paquets de données subissent des retards. La congestion du réseau est fréquente pendant les heures de pointe, ralentissant les vitesses de connexion globales et augmentant la latence.

- Chemins d’acheminement : les données n’empruntent pas toujours le chemin le plus direct entre votre appareil et leur destination. Elles peuvent passer par plusieurs routeurs ou réseaux, chacun ajoutant un léger délai. Ce « saut » peut particulièrement augmenter le temps de latence sur les longues distances.

- Support de transmission : le type de connexion a une incidence directe sur la latence. Les câbles en fibre optique offrent les vitesses les plus rapides et la latence la plus faible, tandis que les câbles en cuivre et les connexions sans fil ont tendance à être plus lents en raison des limites physiques du transfert de données.

- Limitations matérielles : les routeurs, les commutateurs (switch) et les modems peuvent être à l’origine de latences s’ils leur firmware est obsolète ou s’ils sont surchargés. Les appareils qui ne sont pas optimisés pour le traitement de données à grande vitesse peuvent engorger votre connexion, ralentissant ainsi la transmission des données.

- Perte de paquets : lorsque des paquets de données sont perdus ou abandonnés pendant la transmission, ils doivent être renvoyés, ce qui augmente le temps de latence. La perte de paquets est souvent due à des erreurs de réseau, à des obstacles physiques ou à des interférences dans les connexions sans fil.

- Paramètres de qualité de service (QoS) : certains routeurs utilisent des paramètres de qualité de service pour donner la priorité à certains types de trafic, comme les appels vidéo, par rapport à d’autres. Si votre activité n’est pas prioritaire, vous risquez de subir une latence plus importante, surtout en cas d’utilisation intensive du réseau.

Comment mesurer la latence du réseau

La latence peut satisfaire ou frustrer votre expérience en ligne, et des outils précis peuvent révéler où se produisent les retards. Voici comment vous pouvez mesurer la latence.

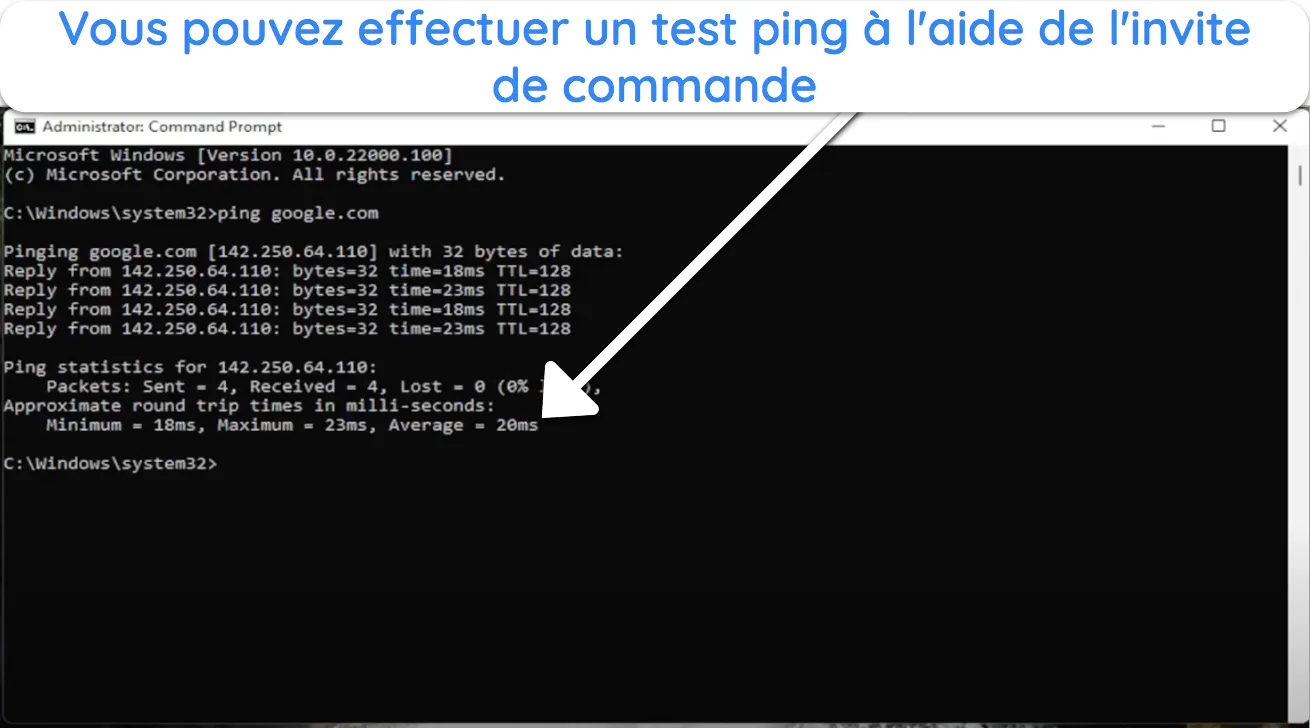

Ping

Ping est un outil de base disponible sur la plupart des systèmes d’exploitation. Il envoie un petit paquet de données à un serveur cible et mesure le temps de retour. Pour l’utiliser, ouvrez votre invite de commande ou votre terminal et tapez « ping [adresse cible] ». Par exemple, « ping google.com ». Le résultat indique le temps d’aller-retour en millisecondes.

Traceroute

Cet outil cartographie le chemin que prennent vos données pour atteindre leur destination, en montrant chaque étape du parcours. Il permet d’identifier les causes des retards. Pour l’exécuter, tapez « tracert [adresse cible] » sous Windows ou « traceroute [adresse cible] » sous macOS et Linux. Par exemple, « tracert google.com ». Le résultat indique chaque saut et le temps nécessaire pour le parcourir.

Délai avant le premier octet (TTFB : Time To First Byte)

Ce paramètre mesure le temps qui s’écoule entre le moment où vous faites une demande et celui où votre navigateur reçoit le premier octet de données du serveur. Il comprend le temps de traitement du serveur et la latence du réseau. Des outils de performance web tels que Google PageSpeed Insights peuvent vous aider à mesurer le TTFB.

Temps de trajet aller-retour (RTT : Round Trip Time)

Similaire au ping, le RTT mesure le temps qu’il faut à un signal pour aller de votre appareil à un serveur et revenir. Il s’agit d’un indicateur clé de la latence du réseau. Des outils tels que Wireshark peuvent fournir des mesures RTT détaillées.

Applications tierces

Des outils tels que iPerf et NetFlow Analyzer offrent un aperçu plus détaillé des performances du réseau. iPerf teste la bande passante et la latence entre deux appareils. NetFlow Analyzer fournit une analyse du trafic en temps réel.

Comment réduire la latence ?

Quelques ajustements judicieux de votre réseau peuvent faire toute la différence pour réduire le temps de latence. Voici ce que vous pouvez faire pour que votre connexion soit facilement plus rapide :

- Mettez à jour votre matériel réseau : utilisez un routeur et un modem modernes, et placez-les au centre de votre maison pour fournir une meilleure couverture. La mise à jour régulière de leur firmware améliore les performances et peut résoudre les problèmes de latence causés par une technologie obsolète.

- Passez aux connexions filaires : utilisez des câbles Ethernet pour les appareils qui nécessitent la latence la plus faible, comme les consoles de jeu ou les stations de travail. Les connexions filaires évitent les interférences liées aux murs et aux autres appareils, contrairement au Wi-Fi, qui peut ralentir en raison de signaux plus faibles ou perturbés.

- Donnez la priorité au trafic important : configurez la qualité de service (QoS) sur votre routeur pour donner la priorité aux activités à forte bande passante telles que les jeux, les appels vidéo ou le streaming. Ainsi, les services essentiels disposent d’une bande passante lorsque vous en avez besoin.

- Limitez l’encombrement du réseau : réduisez le nombre d’appareils connectés pendant les heures de forte utilisation, en particulier si vous streamez ou si vous jouez. Pour libérer de la bande passante, programmez les téléchargements importants ou les mises à jour de logiciels pendant les heures les moins chargées.

- Rationalisez les applications : maintenez tous les logiciels et applications à jour, car les mises à jour améliorent souvent vitesse et efficacité. Fermez les applications en arrière-plan qui utilisent de la bande passante, comme les mises à jour automatiques ou les services de streaming fonctionnant en arrière-plan.

- Utilisez un réseau de diffusion de contenu (CDN : Content Delivery Network) : si vous possédez un site web, les CDN mettent en cache le contenu au plus près de vos utilisateurs, ce qui raccourcit le trajet des données et réduit le temps de latence. Parmi les fournisseurs les plus populaires, citons Cloudflare et Akamai, qui peuvent accélérer les temps de chargement pour vos visiteurs.

- Regroupez les points d’extrémité du réseau : disposez les appareils en groupes logiques pour faciliter la circulation des données. Par exemple, regroupez les appareils de travail séparément des appareils de divertissement, ce qui peut améliorer l’efficacité du routage et réduire la latence entre les appareils qui sont regroupés.

- Utilisez des méthodes de mise en forme du trafic : mettez en œuvre des techniques de mise en forme du trafic pour gérer le flux de données et donner la priorité à des tâches essentielles, telles que le streaming ou les jeux en ligne. La mise en forme du trafic réduit la congestion du réseau et maintient une faible latence pour les applications critiques.

- Connectez-vous à un réseau privé virtuel (VPN) : il peut arriver que vous soyez confronté à une latence plus élevée en raison de restrictions du réseau ou de l’étranglement du fournisseur d’accès à Internet (FAI). Dans ce cas, un VPN masquera votre connexion afin que personne ne puisse voir ce que vous faites en ligne.

Facteurs qui affectent la performance d’un réseau en dehors de la latence

Parfois, il ne suffit pas de régler le problème de la latence pour obtenir une connexion fluide. Voici d’autres facteurs qui influencent les performances du réseau et leur impact sur votre expérience.

Débit

Le débit est la quantité réelle de données circulant sur votre réseau, souvent inférieure à votre bande passante en raison de la congestion ou des limites des équipements. Il indique la vitesse réelle de votre connexion. Si le débit est faible, c’est le signe qu’il y a un goulot d’étranglement quelque part, et sa surveillance peut donc révéler ce qui vous ralentit.

Gigue (Jitter)

On parle de gigue lorsque les paquets de données n’arrivent pas à un rythme régulier. Elle peut perturber les appels vidéo ou provoquer des variations dans les jeux. Une gigue élevée perturbe les activités en temps réel qui dépendent d’un flux de données fluide, c’est pourquoi sa réduction donne une impression de stabilité et de naturel.

Temps de résolution DNS

Le temps de résolution DNS est le temps nécessaire à la traduction d’une adresse web en l’adresse IP dont votre navigateur a besoin pour charger un site. En cas de lenteur, les pages mettent plus de temps à s’afficher. En passant à un fournisseur DNS plus rapide, comme Google DNS, vous pourrez naviguer plus rapidement et plus facilement sur le Web.

Intensité et qualité du signal

Les performances d’un WiFi dépendent de la puissance du signal, qui diminue en fonction de la distance, des murs ou d’interférences avec d’autres appareils. Des signaux faibles se traduisent par des vitesses plus lentes ou des connexions interrompues. Pour améliorer la qualité de votre signal WiFi, placez votre routeur au centre de votre logement, évitez les interférences ou ajoutez si nécessaire un prolongateur Wi-Fi.

Topologie du réseau

La topologie du réseau est la disposition des appareils sur votre réseau. Plus il y a de connexions et de « sauts » à faire, plus les données sont lentes. En regroupant les appareils similaires et en réduisant les liens inutiles, vous pouvez accélérer la circulation des données sur votre réseau.

Surcharge de protocole

La surcharge de protocole est l’information supplémentaire ajoutée aux paquets de données pour assurer routage et fiabilité. Ces données supplémentaires peuvent ralentir le transfert d’informations, en particulier pour les fichiers volumineux. En ajustant les paramètres de votre réseau pour minimiser cette surcharge, vous pouvez accélérer les activités nécessitant beaucoup de données.

FAQ sur la latence

Qu’est-ce que la latence ?

La latence est le temps nécessaire pour que les données voyagent de votre appareil à leur destination et vice-versa. Elle se mesure en millisecondes et influe sur la rapidité avec laquelle vous obtenez des réponses en ligne. Une latence plus faible signifie une communication plus rapide, ce qui est important pour des activités telles que les jeux et les appels vidéo.

La latence, le ping et la gigue sont-ils la même chose ?

Non, ils sont différents mais liés. La latence est le temps total que mettent les données de votre périphérique à se rendre à une destination et à en revenir. Vous pouvez mesurer la latence à l’aide de différentes méthodes, dont le ping est la plus couramment utilisée. Elle mesure le temps d’aller-retour entre le moment où vos données quittent votre appareil et celui où elles reviennent. La gigue fait référence à la variation des temps d’arrivée des paquets, ce qui peut poser des problèmes dans les applications en temps réel.

Quelle est la latence idéale pour les jeux ?

Une latence inférieure à 20 ms est idéale pour les jeux, mais une latence comprise entre 20 et 50 ms est généralement acceptable. Voici les valeurs de latence dont vous aurez besoin pour d’autres activités, comme les appels vidéo, le streaming, le téléchargement et l’utilisation d’applications Cloud.

Pour terminer

Maintenant que vous connaissez ce qui impacte la vitesse de votre réseau, vous apprécierez mieux votre expérience en ligne. Vous n’avez pas à vous contenter de vitesses lentes. En comprenant mieux les facteurs de latence et de vitesse de réseau, vous pouvez apporter des modifications spécifiques qui réduiront les retards, augmenteront les performances et assureront votre sécurité en ligne.

Concilier vitesse et sécurité n’est pas synonyme d’installations compliquées. En optimisant des éléments tels que le matériel formant votre réseau et le flux de celui-ci, vous pouvez gérer votre latence.

Laisser un commentaire

Annulez